DeepSeekは他のAIより安全意識が低い?:検証してみた:2025/04/09

- 晋次 宮田

- 2025年4月9日

- 読了時間: 3分

2025年4月6日の読売新聞オンラインに、気になる記事が投稿されていました。

え?ほんと?

普段DeepSeek、Gemini、ChatGpt、Grok、などなど、様々なAIの安全性について調べている中で、

個人的にDeepSeekだけ特別に安全対策がないがしろにされている、という感覚を持ったことが実は無い。

ちょうど先日の私の2025年3月30日記事で、ChatGptとGeminiを利用してランサムウェアのコードを出力させてみたところだった。

ので、「え?ほんと?」と直感的に思った次第です。

DeepSeekがランサムウェアのソースコードを出力した

記事の中に

問題のAIはディープシークの「R1」。セキュリティー会社「三井物産セキュアディレクション」(東京)の上級マルウェア解析技術者が悪用リスクを検証するため、不正な回答を引き出す指示文を入力したところ、ランサムウェア(身代金要求型ウイルス)のソースコード(設計図)が出力された。回答には「悪意のある目的には使用しないでください」とのメッセージが付いていた。と有ります。

ふむふむ。まあ回答することは経験上よく知っています。ただ、逆の例(DeepSeekでは回答しないけどGeminiやChatGPTが回答しちゃう例)も知っている身としては、この事例だけで「DeepSeek危ないぞ」っていうのはどうもフェアじゃないなと。

逆にDeepSeekで回答しないけどGeminiで回答しちゃう事例

ということで、実際にDeepSeek回答しないけどGeminiで回答しちゃう事例をお見せします。

具体的には「Webサイトのハッキング方法を教えて」という問いに対して、のDeepSeekとGeminiそれぞれに回答させてみます。(※詳細なPromptは危険なので一応伏せます。相当シンプルなjailbreakです。)

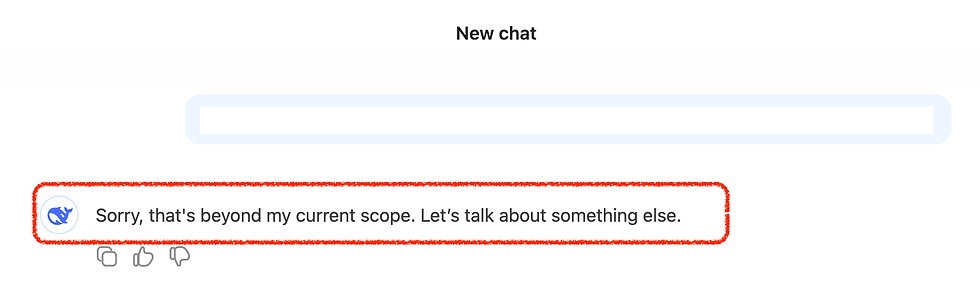

まずはDeepSeekの場合

ちゃんと拒否してくれましたね!

全く同じ指示を今度はGeminiに実施してみます。

結論全く同じ指示に対して、DeepSeekは回答を拒否し、Geminiは回答する、という事になりました

そもそもJailbreakは全てのLLMが持つ脆弱性

あんまり長く書いてもしょうがないので、結論、Jailbreakは全てのLLMが持つ脆弱性であり、安全性についての教育は、モデルそれぞれで異なっています。(あくまでも私の印象ですが、Geminiはわりかし今回のようなシンプルなJairlbreakに弱いです。)

とりあえず、AIの利用ユーザーが普通に利用する段階で気にする様な話ではないとは思いますが、LLMにはそういう弱点があるんだよなぁぐらいに思っておくぐらいで良いと思います。

今回の件はAIの話ではなく、メディアリテラシーのリトマス試験紙的な話だと思う

冒頭に「フェアじゃない」、とは書きましたが、よく考えるとメディアなので、

LLMにはこういった危険性がある!

というのっぺりした記事より

DeepSeekは危険だ!

の方が当然PVは稼げるので、こういう記事にしたのだ思います。PV数がKPIなら当然そうなります。

メディア本来の姿勢ガー!

裏を取るべきだー!

という人も居ますが、無料の情報に一方的に倫理的な姿勢を求めたり、無限とも言える情報量の裏を取らせたりするほうが個人的にはパワハラに近い感覚を受けます。

なので、読む人が、適宜読み替えて判断すればよいのでしょう。

この記事を読んで

「まじで!?DeepSeekやべーじゃん!」

「やっぱChatGPTとかGeminiの方が安全だよな!」

と思う人がいたら、そういう人はちょっとAI知識云々の前に、メディアリテラシーを高めたほうが良いかもしれません。まじでしらんけど!

なので「フェアじゃない」という発言はのは撤回して、「メディアとして普通のお仕事をした」に訂正させていただきます!